医療分野におけるChatGPT、LLM、生成AIに関する勉強会の詳細紹介_後編

本記事は後半の記事となります。

前半記事; 医療分野におけるChatGPT、LLM、生成AIに関する勉強会の詳細紹介_前編

京大病院放射線診断科火曜カンファで利用した登壇資料をベースにして、AIやデータプロダクトを専門とするプロダクトマネージャーからみた医療分野におけるChatGPTやLLM(大規模言語モデル)、生成AIの利活用の現状や限界などを説明させていただければと思います。

関連記事;京大病院放射線診断科火曜カンファにてChatGPT、LLM、生成AIに関する勉強会を開催させていただきました。

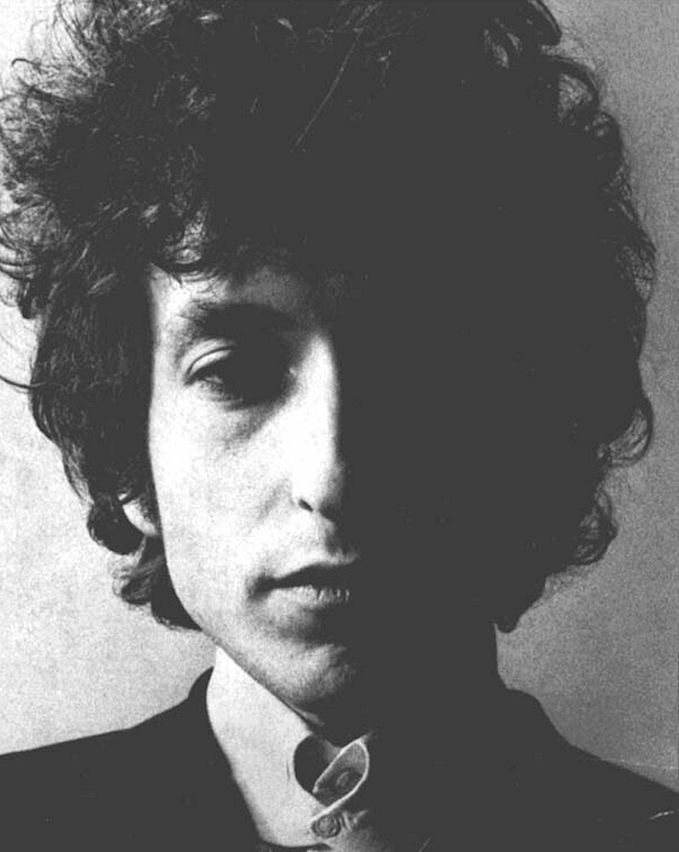

自己紹介

硴﨑裕晃(Kakizaki Hiroaki)

株式会社MICIN データソリューション部 プロダクトマネージャー

Megagon Labs(Recruit Holdings Co.,Ltd.がシリコンバレーと東京に保有する AI 研究所)などを経てMICINに参画。自然言語処理、画像認識、信号処理、マルチモーダル、医療AI(SaMD)、データマネジメントプラットフォーム等様々なAI関連プロダクトのプロダクトマネジメントをこれまでに担当した。

勉強会の詳細④;Large Language Model (LLM)と自然言語処理について

こちらのパートでは自然言語処理の基本、LLM登場以前と登場後で実務的に何が変化したのか、及び医療分野に特化した大規模言語モデルなどを紹介させていただきました。

自然言語処理について基礎から学びたい方には以下の書籍をお勧めしています。

先述させていただいたGoogle社のBERTなどの登場以前は人手でコーパスを用意してタスクを与えたり、言語理解を獲得させたりという流れが一般的でした。しかしこの手法の場合、人手などの資源に限界があるためコーパスのスケール性に課題がありました。

特に医療分野においてはそもそもデータ収集が難しいことに加え、アノテーション自体に専門的な知識が必要になることから大規模なデータセット・コーパスの構築が非常に難易度が高いという課題がありました。

一方でLLMはこれらの課題に対してインターネット上の大量のコーパスを使って人手を介さずモデルを学習させることで言語理解を獲得させようというのがモチベーションにあります。この自己教師あり学習(Self Supervice Learing; SSL)と呼ばれる手法により、LLMが非常に高い水準の言語理解を獲得できるようになったことが近年の自然言語処理のトレンドの一つでした。ChatGPTもこれらの大きな流れの中から登場した技術になります。

このようにしてトレーニングされたLLMはインターネット上の情報を活用していることから汎用的なモデルとなりますが、これらのLLMに対して専門的な知識をさらに学習させることで特定の用途に特化した大規模言語モデルを作成することが可能です。

医療分野でも様々な特化型の大規模言語モデルが提案されています。

- BioBERT (Lee et al. 2019)

- BioBERT: a pre-trained biomedical language representation model for biomedical text mining

- Clinical BERT (Alsentzer et al, 2019)

- Publicly Available Clinical BERT Embeddings

- BlueBERT (Pen et al. 2019)

- Transfer Learning in Biomedical Natural Language Processing: An Evaluation of BERT and ELMo on Ten Benchmarking Datasets

- BioMegatron (Shin et al. 2020)

- BioMegatron: Larger Biomedical Domain Language Model

- PubMedBERT (GU et al. 2021)

- Domain-Specific Language Model Pretraining for Biomedical Natural Language Processing

- GatorTron (Yang et al. 2022)

- A large language model for electronic health records

勉強会の詳細⑤;Generative AIの医療応用研究

こちらのパートではChatGPTやLLMに限らず、Generative AIの医療応用研究について5つの論文を紹介させていただきました。

なおGenerative AIとはテキスト・画像・音声など様々なコンテンツを生成する深層学習モデルの総称です。Generative AIはマルチモーダルの文脈で使われることが多い(NLPだと単にGenerative Modelなどと呼ばれる)ですが、ChatGPTもテキストを生成するGenerative AIの一つとされています。

今回の勉強会で取り上げた論文は以下の5つになります。詳細は割愛しますが、それぞれ概要だけこちらのブログでも記載させていただきます。

①Making the Most of Text Semantics to Improve Biomedical Vision — Language Processing

- 胸部X線の画像とレポートをペアにした自己教師あり学習に関する研究です。

- レポートに特化した言語モデル(CXR-BERT)を開発し、エンコーディングしています。

- 画像の疾患分類において、Zero-shotとFew-shotで既存のモデルよりも性能が高いことを示しました。

- BioViLと同様に胸部X線の画像とレポートをペアにした自己教師あり学習を提案しています。

- CLIPの学習済みモデルを胸部X線の画像とレポートを用いてドメイン適応させています。

- 画像の疾患分類のタスクにおいて、Zero-shotながら一部の疾患において、既存の教師ありモデルに匹敵する性能を達成しています。

③Adapting Pretrained Vision-Language Foundational Models to Medical Imaging Domains

- Diffusion Modelを応用し、プロンプトから胸部X線の画像を生成する手法を提案しました。

- 既存のDiffusion Modelは、ドメイン適応が難しく、リアルなX線画像を生成できません。

- 正常・異常(胸水あり)の画像を5枚ずつ用意して、 fine-tuningを行うことで、プロンプトの入力に応じて、リアルな正常・異常の画像が生成可能であることを示しました。

④Automated radiology report generation using conditioned transformers

- 画像から放射線レポートの自動生成は画像×テキストのマルチモーダルのホットなトピックの1つです。

- GPT2をベースにして、レポートの自動生成に取り組んだ研究になります。

⑤Medically Aware GPT-3 as a Data Generator for Medical Dialogue Summarization

- GPT-3を使用して、医療会話の要約に取り組んだ研究です。

これらの研究はそのほとんどが2021年〜2022年にかけて発表されたものになるため、特に医療分野におけるGenerative AIに関しては世界最先端の米国においても未だ試行錯誤の段階だということがわかります。

またこれらの研究成果の多くは米国や英語圏のデータセット・コーパスに基づいて研究開発が実施されているため、日本を含めた米国外・英語圏外の国々でそのまま活用することが難しい可能性が高いです。従って日本においても固有のデータセットを用いた研究開発が望まれています。

勉強会の詳細⑥;ChatGPTやLLMの主な論点と今後の展望

本勉強会の最後のパートでは「大規模言語モデルの課題」「大規模言語モデルそのものの展望」「セキュリティ、個人情報関連」について軽く触れさせていただきました。

繰り返しになりますが大規模言語モデルの課題としては「ハルシネーション」が非常に有名です。一般的な商用プロダクトにおいては致命的な悪影響がでない場合でも、医療においては求められる品質水準が大きく異なることからAIに限らず新しい技術の導入には慎重になる必要があります。

その他にも医療においては「そもそもそれってAIでやっていいんだっけ?」というような倫理的な観点も忘れてはいけません。(参考;「AI技術とベッドサイドの間」にある障壁 )

上記のように臨床現場でのAI利活用においては多くの課題が残されていますが、だからこそ医師の先生方をはじめとした医療従事者の皆様や、患者さん、製薬会社さんや医療機器メーカーさん、規制団体の方々といった多種多様なステークホルダーと一緒に「より良い医療を実現するためにはどうすれば良いのか?」を問い続ける必要があると個人的には考えています。

大規模言語モデルそのものの展望としてはOpenAI CEOがGPT-5の開発は実施していないとコメントしていることから、大規模言語モデルの大規模化は一服した可能性があります。(参考; OpenAIのCEO、「巨大AIモデルを用いる時代は終った」と語る )

今後は強化学習を含めた周辺分野や、各ドメイン・タスク別に特化したモデルの進化、大規模モデルの軽量化などが進むかもしれません。

また特に医療分野でのAI利活用においては避けることができないセキュリティや個人情報関連についても、昨今の状況を見るとLLMに限らずAIやデータ利活用に関して今後さらに求められる要件が上がる可能性があります。

これらに関連する技術としてはエヌビディア社が特に推している連合学習などの手法があり、引き続きLLMに限らず技術の進展には注意を払う必要があります。

最後に

我々MICIN データソリューション部 は引き続き、LLMや生成AIの性能限界を踏まえた適切な応用、および最新技術の臨床現場への活用についてさらなる研究や開発を進めて参ります。

備考;本ブログ、研究内容、勉強会に関してご相談事項などがある方は以下からご連絡ください。